MedGPT:基于权威RAG评估框架展现优秀医疗性能

检索增强生成(RAG,Retrieval-Augmented Generation)技术正革新AI应用领域,它整合外部知识库与 LLM(Large Language Model,大语言模型)内部知识,提高了 AI 系统的准确性和可靠性。多模态知识提取器的知识“召回能力”直接决定了大模型在回答推理时能否获得准确的专业知识。

但随着 RAG 系统广泛应用,其评估和优化面临挑战。现有的评估方法难以全面体现 RAG 系统的复杂性和实际表现。近日,亚马逊、上海人工智能研究院推出 RAGChecker 诊断工具,可为 RAG 系统提供细粒度、全面且可靠的诊断报告,并指明提升性能的操作方向。

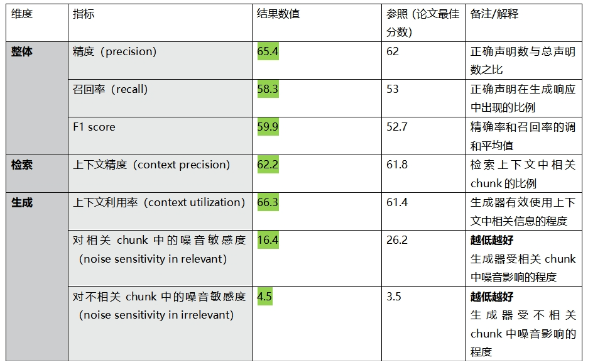

RAGChecker框架设计了包括整体指标、诊断检索器指标和诊断生成器指标在内的一套全面评估体系。通过对包含查询、文档和真实答案的样本进行输入,并借助大型语言模型将文本分解为独立的声明再通过另一个模型验证每个声明的准确性,实现对模型的细粒度评估。

在相关研究中,RAGChecker经过严格的实验验证,其与人类判断的相关性远超 BLEU、ROUGE、BERTScore 等传统评估指标,这充分彰显了其科学性和可靠性。RAGCHECKER的指标还可以帮助实践者开发和评估更有效的RAG系统,并通过调整RAG系统的设置(如检索器的数量、块大小、块重叠比例和生成提示)来提供改进建议。基于这样一个权威的评估框架,我们对MedGPT这一医疗垂直大模型进行了全面的性能测试。

Figure:Illustration of the proposed metrics in RAGChecker

本次测试选取了30个来自专业医生模拟的医疗专业问题,测试结果显示,MedGPT 在多个关键指标上展现出了显著的优势。

在整体评估方面(衡量整个RAG流程的整体质量),MedGPT 的精度(precision)达到了 65.4,召回(recall)为 58.3,F1 score达到 59.9,这些指标相较于参考原文中提到其他模型的更佳分数在表现出更优的得分。这意味着 MedGPT 在处理医疗问题时,能够更精准地命中关键信息,并且全面地覆盖问题相关的知识领域,为医疗决策提供有力的数据支持。

在检索维度上(查找相关信息的优势和劣势能力),上下文精度(context precision)达到 62.2。这表明 MedGPT 在检索医疗知识时,能够以较高的精准度筛选出与问题紧密相关的内容,确保为后续的答案生成提供高质量的素材。

而在生成维度(利用检索到的上下文、处理嘈杂信息以及生成准确和忠实响应的能力),MedGPT 更是表现出了优秀的性能。其上下文利用率(context utilization)为 66.3,充分体现了它能够高效地整合和运用检索到的医疗知识。

模型生成响应中不正确声明在相关 chunk 中的噪音敏感度(noise sensitivity in relevant),MedGPT 仅为 16.4;模型生成响应中不正确声明在不相关 chunk 中的噪音敏感度(noise sensitivity in irrelevant)为 4.5,这一数据有力地证明了 MedGPT 在处理复杂医疗信息时,具有出色的抗干扰能力,能够有效过滤掉无关的噪音信息,专注于生成准确、有价值的答案。综合来看,MedGPT 在医疗垂直领域的表现已经相当突出,能够为医疗专业人士和患者提供可靠、准确的医疗知识和建议。

上述测试结果有力地证实,MedGPT 作为专注于医疗领域的垂直大模型,在应对医疗专业问题时呈现出了优秀的性能表现。以其高精准度、高度可靠性以及强大的抗干扰能力,在医疗人工智能领域中崭露头角。无论是辅助医疗人员进行病症诊断,还是为患者提供专业的医疗咨询服务,MedGPT无疑将会是非常理想的选择,能够为医疗行业的智能化进程提供强劲的推动力。